前言:

hadoop 2.x版中的hbase跟zookeeper安裝跟hadoop 1.x這版的並無不同,所以一些設定檔說明就不贅述了,可以google或是看我以前的網誌

步驟一:

把下載的hbase跟zookeeper解壓縮到家目錄,並在/home/pablo/data/中新增hbase跟zookeeper兩個資料夾

步驟二:

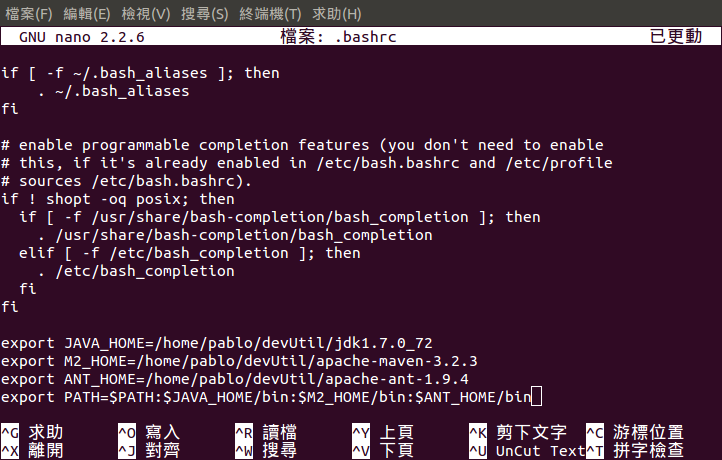

編輯環境變數,在.bashr

export HBASE_HOME=/home/pablo/hbase-0.98.9-hadoop2

export ZOOKEEPER_HOME=/home/pablo/zookeeper-3.4.6

步驟三:

編輯hbase以及zookeeper的設定檔

hbase部分要編輯的設定檔是下圖三個

zookeeper部分要在${zookeeper_HOME}/conf下把zoo_sample.cfg複製一份並改名成zoo.cfg,再zoo.cfg最下面加入兩行

dataDir=/home/pablo/data/zookeeper

server.1=UB104:2888:3888

接著在/home/你的名稱/data/zookeeper中加入一個myid並寫入1的檔案

以上就是安裝過程,下個步驟就是啟動

步驟四:

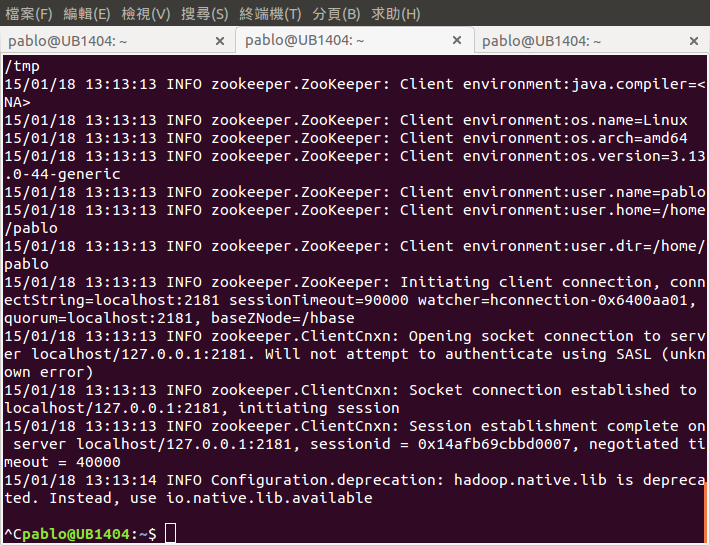

啟動hbase要先啟動hadoop跟zookeeper,指令如下圖中

如果一切都沒問題的話會看到以上兩張圖,也可以用hbase web介面看看,在瀏覽器網址列輸入UB1404:60010會看到下圖

步驟五:

完成了以上安裝後,來試試看hbase建立table跟寫入data是否正常,我們先下載一個jar(點這裡下載) ,這是我寫好的一個程式,怕是病毒的話就不要下,不過在vm是很強大的防毒軟體,不會感染到你的host

下一篇會用ecplise寫好直接執行,我要打包成jar是因為完全分散模式沒有像單機版一樣的使用者介面讓我們寫code,所以我採取在單機版上寫好測試完畢上傳到namenode中去跑程式

下載後執行hadoop har cars.jar

正常執行完會像以下畫面

再開另一個終端機tab,輸入hbase shell進入後再輸入list,就會看到我們剛才執行jar所產生的table:cars

輸入scan 'cars'就會看table中的內容

以上就是本篇的內容,下一篇會編譯跟安裝hadoop eclipse plugin,如此才可以在單機版上開發測試yarn程式或hbase程式,謝謝觀看